https://github.com/Zuzed22/Machine-Learning.git

Hola Zuleika, espero que estés bien

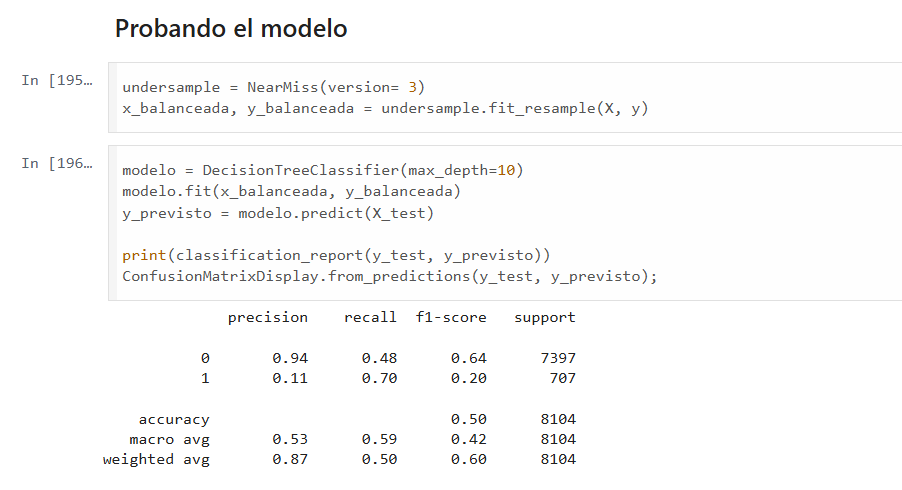

Parece que estás trabajando en un proyecto de clasificación y estás utilizando un modelo de árbol de decisión con una técnica de submuestreo llamada NearMiss para balancear tus datos. Aquí hay algunas observaciones y sugerencias que podrían ayudarte:

Balanceo de Datos: Estás usando NearMiss para balancear las clases. Esto puede ser útil si tienes un conjunto de datos desbalanceado. Sin embargo, ten en cuenta que podrías estar eliminando datos importantes de la clase mayoritaria. Considera también probar técnicas como el sobremuestreo con SMOTE.

Profundidad del Árbol: Has configurado max_depth=10 para tu árbol de decisión. Esto ayuda a evitar el sobreajuste, pero también podría limitar la capacidad predictiva del modelo. Podrías experimentar con diferentes valores de max_depth y usar validación cruzada para encontrar el mejor ajuste.

Métricas de Evaluación: La precisión, recall y f1-score son métricas clave para evaluar el rendimiento de tu modelo. Observa que el recall para la clase minoritaria (1) es relativamente bajo. Podrías intentar ajustar el modelo o probar diferentes algoritmos para mejorar este valor.

Matriz de Confusión: La matriz de confusión te da una buena idea de cómo se están clasificando las instancias de cada clase. Analiza los errores de clasificación para entender mejor dónde está fallando tu modelo.

Pruebas Adicionales: Considera realizar más pruebas con diferentes algoritmos de clasificación, como Random Forest o Gradient Boosting, para ver si puedes mejorar los resultados.

Espero que estas sugerencias te sean útiles para avanzar en tu proyecto. ¡Bons estudios!