No logre replicar la app seleccion_modelo vista en OPenAI PLayground pero para Google AI Studio.

Vale decir que para consultar y ver diferencias de tokens por modelo en OPenAI es en local (sin costo), en Google AI Studio es por consulta API (lleva costa si estamos fuera de la capa gratuita).

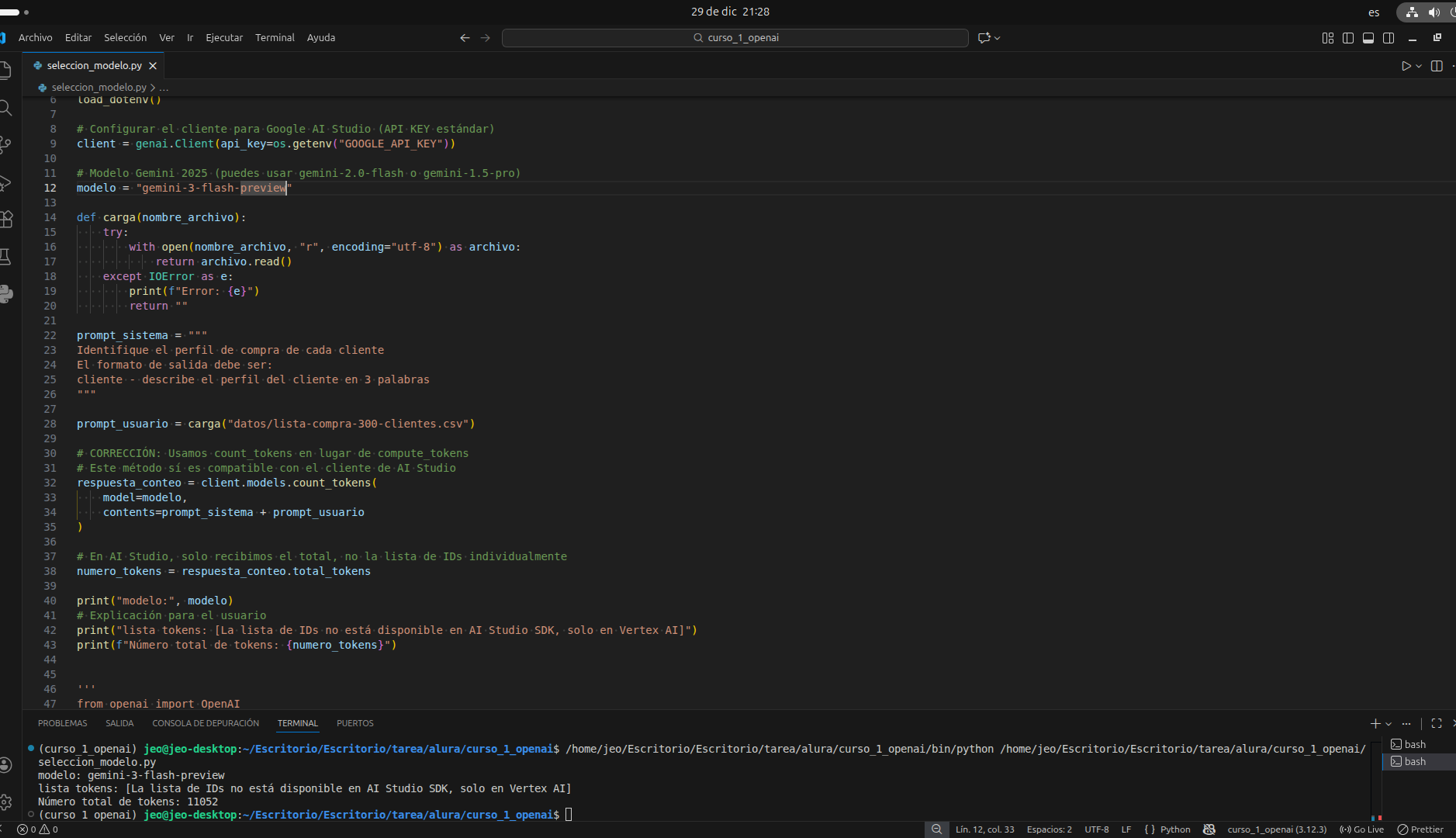

código más similar posible:

import os

from google import genai

from dotenv import load_dotenv

# Cargar variables de entorno

load_dotenv()

# Configurar el cliente para Google AI Studio (API KEY estándar)

client = genai.Client(api_key=os.getenv("GOOGLE_API_KEY"))

# Modelo Gemini 2025 (puedes usar gemini-2.0-flash o gemini-1.5-pro)

modelo = "gemini-3-flash-preview"

def carga(nombre_archivo):

try:

with open(nombre_archivo, "r", encoding="utf-8") as archivo:

return archivo.read()

except IOError as e:

print(f"Error: {e}")

return ""

prompt_sistema = """

Identifique el perfil de compra de cada cliente

El formato de salida debe ser:

cliente - describe el perfil del cliente en 3 palabras

"""

prompt_usuario = carga("datos/lista-compra-300-clientes.csv")

# CORRECCIÓN: Usamos count_tokens en lugar de compute_tokens

# Este método sí es compatible con el cliente de AI Studio

respuesta_conteo = client.models.count_tokens(

model=modelo,

contents=prompt_sistema + prompt_usuario

)

# En AI Studio, solo recibimos el total, no la lista de IDs individualmente

numero_tokens = respuesta_conteo.total_tokens

print("modelo:", modelo)

# Explicación para el usuario

print("lista tokens: [La lista de IDs no está disponible en AI Studio SDK, solo en Vertex AI]")

print(f"Número total de tokens: {numero_tokens}")

motivos según Google navegador modo IA: